Je m’y prend de plus en plus tard, mais voici ma revue de la semaine du dimanche soir, bonsoir !

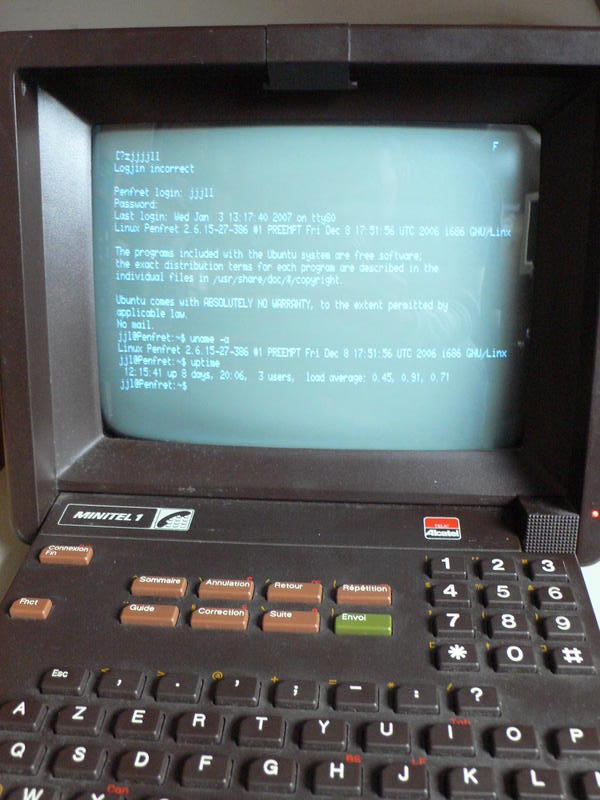

Le minitel 2.0 dans le cloud ?

Benjamin Bayart le rappelait : la centralisation des structures est à l’opposé de la philosophie d’Internet. Ces réflexions ne “parlent” peut être qu’aux vieux croûtons dans mon genre qui ont bossé pendant la période “d’avant le net”, mais rappeler le simple fait qu’un ordinateur connecté sur le réseau, tout aussi modeste soit-il, fait partie intégrante, et active, du réseau est une information qu’il est important de rappeler parfois !

Benjamin Bayart le rappelait : la centralisation des structures est à l’opposé de la philosophie d’Internet. Ces réflexions ne “parlent” peut être qu’aux vieux croûtons dans mon genre qui ont bossé pendant la période “d’avant le net”, mais rappeler le simple fait qu’un ordinateur connecté sur le réseau, tout aussi modeste soit-il, fait partie intégrante, et active, du réseau est une information qu’il est important de rappeler parfois !

Comme souvent, l’évolution des pratiques “underground” est un bon indicateur de l’évolution d’une technologie. Pour le téléchargement, qu’il soit légal ou non d’ailleurs (mais bon, ne nous fermons pas les yeux…), on est passé d’un flux passif style FTP à du Peer-to-peer où tous les postes jouaient un rôle actif. Mais cette évolution, trop “implicante” pour certaines activités, fait de plus en plus place à du téléchargement à nouveau unilatéral, simplement en remplaçant un serveur unique par un maillage de serveurs (sous la forme de newsgroups ou autre) situé dans des zones peu regardantes juridiquement. C’est d’ailleurs au passage cette évolution qui rend des actions telles qu’Hadopi complètement obsolètes.

Et il ne faut pas oublier que c’est exactement ce qui se passe avec le “cloud” qu’on nous annonce : autant, j’ai pu en discuter sur ce blog, je suis assez enthousiaste sur la forme que peuvent prendre ces applications, autant je reste très soucieux et sceptique sur ce retour à un “minitel 2.0”, ou plutôt à une structure très “mainframe” qui est l’héritage direct de la préhistoire de l’informatique. Cet article assez intéressant du Monde informatique rajoute une pierre à ces inquiétudes : ce mode “cloud”, reprend certes l’architecture technique du minitel 2.0, mais aussi et surtout préfigure d’un retour… de son modèle économique !

Ma préconisation reste la même : il faut savoir anticiper et développer ce mouvement qui amène des perspectives très excitantes, en particulier en terme de travail collaboratif (Google Wave n’est qu’un premier pas, très imparfait, mais qui nous montre la voie de l’avenir) ; à mon sens, le meilleur moyen de préserver ses libertés personnelles de cette nouvelle façon de voir le web est de s’y impliquer le plus fort possible, tout en restant extrêmement vigileant. Je pense en particulier aux mouvements “libristes” qui sont philosophiquement aux antipodes de cette informatique très centralisée et contrôlée, et pourtant techniquement au coeur de ces préoccupations, les Linux & co étant des briques quasi omniprésentes dans ces solutions.

CEO ou grand manitou ?

En parlant de “libristes”, Mark Shuttleworth, le patron de Canonical, à l’origine du projet Ubuntu, a annoncé cette semaine qu’il passait la main sur les fonctions de direction de sa société.

Ce genre d’opération est plutôt courant (on se souvient de la façon dont les deux créateurs de Google ont rapidement cédé les rênes de la société à un “gros bonnet” tout en restant à des places stratégiques) et assez symptomatique : à croire qu’amorcer une société, trouver l’idée, la faire naître et grandir, n’est pas le même travail que de la maintenir et la porter à bout de bras sur du moyen/long terme.

Même Steve Jobs, si souvent cité en exemple, n’a pas vraiment pu assumer ces deux rôles : ou plutôt, il a pu, mais avec une parenthèse d’une bonne dizaine d’années, le temps d’atteindre une certaine maturité. Un des rares contre-exemples qui me vient à l’esprit est celui de Bill Gates, qui a porté son entreprise pendant plus de 20 ans.

Et ces changements à la tête d’une entreprise s’avèrent souvent bénéfiques, une sorte de “nouvelle dynamique” pour la société. Instructif !

Free goes mobile

Après des mois et des mois de négociation, c’est enfin officiel : Free est possesseur de la 4ème licence mobile en France. Tout le monde attend maintenant de voir ce qui va ressortir de cette nouvelle donne. Xavier Niel a donné une interview dans laquelle il donne quelques indications sur la ligne qu’il entend tenir.

Premier point : la “non-entente” avec les concurrents, condition primordiale selon lui pour arriver à casser un peu la logique des choses. Sous entendu : halte aux arrangements et aux alignements entre “concurrents”. Ne serait ce qu’avec l’exemple édifiant des SMS, véritable manne maintenue pendant des années alors que le coût était quasi nul, on ne peut qu’acquiesser.

Mais c’est bien entendu techniquement qu’on attend Free au tournant : rappelons qu’historiquement, la notion de “box” vient d’eux. Et on attend bien entendu quelque chose d’équivalent pour cette future offre “quadruple-play”. Rappelons que Free est également actif dans le domaine du WiMax, pourquoi pas directement un “quintuple-play” avec une offre globalisant accès Internet pour son ordinateur (WiFi à domicile, WiMax/3G à l’extérieur) et téléphonie (Box à domicile, et GSM/WiMax à l’extérieur) ? Une belle occasion en tout cas, si cela se fait, pour que la France reprenne quelques longueurs d’avance ! Vivement 2011, donc…

Blu-ray ou pas ?

Noël est souvent une période clé pour amorcer la migration vers une nouvelle techno grand public. Que ça soit pour le Netbook, le DVD, l’écran plat, la plupart des “adoptions” par le grand public de produits en phase d’amorçage se sont fait sur la période de Noël. A l’opposé, d’autres technologies moins chanceuses, telles que le HD-DVD, sont mortes après étude des ventes de fin d’années (Février 2008 pour le HD-DVD). J’étais donc curieux de voir le bruit que ferait le Blu-ray sur cette fin d’année 2009.

En effet, voici maintenant 3 ans que l’offre existe (la PlayStation 3, premier lecteur Blu-ray grand public, existe depuis fin 2006). Et pourtant, autant les écrans plats sont de plus en plus courants, autant la diffusion télé (autant satellite que hertzienne, surfant sur le rééquipement numérique TNT) arrive à suivre le mouvement (la télé étant pourtant rarement sur des phases d’amorçage de nouvelles technologies), autant le Blu-ray reste désespérément à la traîne. Il est encore trop tôt pour analyser les résultats des ventes de ce Noël 2009, mais les raisons sont multiples :

- La plus value, même si elle est indéniable par rapport au DVD, reste trop faible. Lorsqu’on est passé du VHS au DVD, c’était pour une meilleure qualité, mais aussi et surtout pour ne plus avoir à rembobiner des cassettes fragiles et encombrantes. Là, on continue à manipuler un disque.

- Le blu-ray n’a pas d’intérêt sans un rééquipement global (écran/home cinéma audio) et les notions de haute définition ont souvent été mal vendues et trop complexes

- Le blu-ray est bien mieux protégé que le DVD contre les copies. Cela pourrait être un atout, mais cela s’avère être au contraire un formidable vecteur de publicité… pour les formats numériques non protégés.

C’est bien le paradoxe de la protection : un DVD pouvait être copiable, ou au pire convertible en DiVX. Là, on arrive à un extrême où il est bien plus simple et agréable de posséder des films en numérique HD sur un disque dur. En d’autres termes, le blu-ray est en train de pousser la population à se passer de platines de lectures, et d’investir à la place dans de gros boîtiers de stockage !

Les fabricants ont su prendre la bonne décision : aller directement vers la génération d’après, en publiant les spécifications du Blu-ray 3D. Ce format semble faire l’unanimité : il maintient une compatibilité ascendante avec “l’ancien” blu-ray, exploite le format 1080P des écrans les plus performants, et surtout… arrive pile à temps pour montrer dans de bonnes conditions les productions les plus récentes du cinéma hi-tech (le film Avatar de James Cameron, gros carton de cette fin d’année, en tête).

A la semaine prochaine !